Đánh giá cấu trúc và điểm chuẩn trong chẩn đoán mô tuyến giáp còn sót lại trên bộ dữ liệu xạ hình tuyến giáp

633 lượt xemDOI:

https://doi.org/10.54939/1859-1043.j.mst.88.2023.131-138Từ khóa:

Chụp cắt lớp phát xạ đơn photon; Xạ hình tuyến giáp; Hỗ trợ chẩn đoán bằng máy tính CADx.Tóm tắt

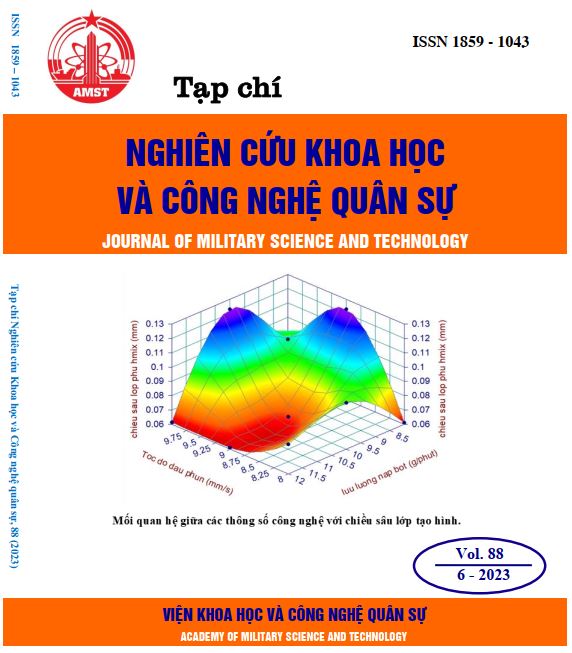

Xạ hình tuyến giáp, một loại kỹ thuật chụp cắt lớp vi tính phát xạ photon đơn (SPECT) sử dụng đồng vị phóng xạ để chụp ảnh tuyến giáp, giúp phát hiện các bất thường về tuyến giáp và chẩn đoán ung thư tuyến giáp. Một hướng nghiên cứu triển vọng ứng dụng học máy hỗ trợ trong chẩn đoán. Hầu hết các thuật toán để phát hiện và dự đoán sự hấp thu ở vùng tuyến giáp đều dựa trên các bộ dữ liệu độc quyền hoặc đã công bố với thông tin không xác định. Điều này làm cho việc so sánh hiệu suất giữa các phương pháp khác nhau và phát triển các giải pháp cho các vấn đề trở nên khó khăn. Để giải quyết vấn đề này, chúng tôi đã xây dựng hai bộ dữ liệu tiêu chuẩn về hình ảnh xạ hình tuyến giáp để xác định và định lượng độ sâu vùng quan tâm. Mục đích của việc thiết kế các mô hình là để thiết lập đánh giá chuẩn cho việc phát triển các mô hình CADx trên bộ dữ liệu trong tương lai.

Tài liệu tham khảo

[1]. Karssemeijer, N. & te Brake, G. M, “Detection of stellate distortions in mammograms,” IEEE Trans. Med. Imaging, Vol. 15, No. 5, pp. 611–619, (1996). DOI: https://doi.org/10.1109/42.538938

[2]. Mudigonda, N. R., Rangayyan, R. M. & Desautels, J. E. L, “Detection of breast masses in mammograms by density slicing and texture flow-field analysis,” IEEE Trans. Med. Imaging, Vol. 20, No. 12, pp. 1215–1227, (2001). DOI: https://doi.org/10.1109/42.974917

[3]. Liu, S., Babbs, C. F. & Delp, E. J, “Multiresolution detection of spiculated lesions in digital mammograms,” IEEE Trans. IMAGE Process, Vol. 10, No. 6, pp. 874–884, (2001). DOI: https://doi.org/10.1109/83.923284

[4]. Li, L., Clark, R. A. & Thomas, J. A, “Computer-aided diagnosis of masses with full-field digital mammography,” Acad. Radiol, Vol. 9, No. 1, pp. 4–12, (2002). DOI: https://doi.org/10.1016/S1076-6332(03)80290-8

[5]. Baum, F., Fischer, U., Obenauer, S. & Grabbe, E,” Computer-aided detection in direct digital full-field mammography: initial results,” Eur. Radiol, Vol. 12, No. 12, pp. 3015–3017, (2002). DOI: https://doi.org/10.1007/s00330-002-1393-3

[6]. Kim, S. J. et al, “Computer-aided detection in digital mammography: Comparison of craniocaudal, mediolateral oblique, and mediolateral views,” Radiology, Vol. 241, No.3, pp. 695–701, (2006). DOI: https://doi.org/10.1148/radiol.2413051145

[7]. Yang, S. K. et al, “Screening mammography—detected cancers: Sensitivity of a computer-aided detection system applied to fullfield digital mammograms,” Radiology, Vol. 244, No. 1, pp. 104–111, (2007). DOI: https://doi.org/10.1148/radiol.2441060756

[8]. The, J. S., Schilling, K. J., Hoffmeister, J. W. & Mcginnis, R, “Detection of breast cancer with full-field digital mammography and computer-aided detection,” Am. J. Roentgenol, Vol. 192, No. 2, pp. 337–340, (2009). DOI: https://doi.org/10.2214/AJR.07.3884

[9]. Sadaf, A., Crystal, P., Scaranelo, A. & Helbich, T, “Performance of computer-aided detection applied to full-field digital mammography in detection of breast cancers,” Eur. J. Radiol, Vol. 77, No. 3, pp. 457–461, (2011). DOI: https://doi.org/10.1016/j.ejrad.2009.08.024

[10]. Yinxiang Guo et al. “Classification and diagnosis of residual thyroid tissue in SPECT images based on finetuning deep convolutional neural network”. In: Frontiers in Oncology 11 (2021). DOI: https://doi.org/10.3389/fonc.2021.762643

[11]. S. J. Pan and Q. Yang, “A survey on transfer learning,” IEEE Transactions on Knowledge and Data Engineering, vol. 22, no. 10, pp. 1345–1359, (2010). DOI: https://doi.org/10.1109/TKDE.2009.191

[12]. A. Z. Abidin, B. Deng, A. M. DSouza, M. B. Nagarajan, P. Coan et al., “Deep transfer learning for characterizing chondrocyte patterns in phase contrast X-Ray computed tomography images of the human patellar cartilage,” Computers in Biology and Medicine, vol. 95, pp. 24–33, (2018). DOI: https://doi.org/10.1016/j.compbiomed.2018.01.008

[13]. Q. H. Nguyen, B. P. Nguyen, S. D. Dao, B. Unnikrishnan, R. Dhingra et al., “Deep learning models for tuberculosis detection from chest X-ray images,” in Proc. of 26th International Conference on Telecommunications, pp. 381–385, (2019). DOI: https://doi.org/10.1109/ICT.2019.8798798

[14]. P. Hai, N. Thanh, N. Trung, and T. Kien, “Transfer Learning for Disease Diagnosis from Myocardial Perfusion SPECT Imaging”, Comput. Mater. Contin., vol. 73, no. 3, Art. no. 3, (2022), doi: 10.32604/cmc.2022.031027. DOI: https://doi.org/10.32604/cmc.2022.031027

[15]. C. Zhang, K. Qiao, L. Wang, L. Tong, G. Hu et al., “A visual encoding model based on deep neural networks and transfer learning for brain activity measured by functional magnetic resonance imaging,” Journal of Neuroscience Methods, vol. 325, no. 108318, (2019). DOI: https://doi.org/10.1016/j.jneumeth.2019.108318

[16]. Karen Simonyan, Andrew Zisserman, “Very Deep Convolutional Networks for Large-Scale Image Recognition,” arXiv: 1409.1556, (2014).

[17]. Christian Szegedy, Vincent Vanhoucke, Sergey Ioffe, Jonathon Shlens, Zbigniew Wojna, “Rethinking the Inception Architecture for Computer Vision,” arXiv:1512.00567 (2015). DOI: https://doi.org/10.1109/CVPR.2016.308

[18]. Kaiming He, Xiangyu Zhang, Shaoqing Ren, Jian Sun, “Deep Residual Learning for Image Recognition,” arXiv: 1512.03385 (2015).

[19]. François Chollet, “Xception: Deep Learning with Depthwise Separable Convolutions”, arXiv: 1610.02357 (2017) DOI: https://doi.org/10.1109/CVPR.2017.195

[20]. Mark Sandler and Andrew Howard and Menglong Zhu and Andrey Zhmoginov and Liang-Chieh Chen, “MobileNetV2: Inverted Residuals and Linear Bottlenecks”, arXiv: 1801.04381 (2019) DOI: https://doi.org/10.1109/CVPR.2018.00474

[21]. Barret Zoph and Vijay Vasudevan and Jonathon Shlens and Quoc V. Le, “Learning Transferable Architectures for Scalable Image Recognition”, arXiv: 1707.07012 (2018). DOI: https://doi.org/10.1109/CVPR.2018.00907

[22]. Mingxing Tan, Quoc V. Le, “EfficientNet: Rethinking Model Scaling for Convolutional Neural Networks,” arXiv: 1905.11946 (2019).