Hệ thống phát hiện khói và cháy thông minh đa thể thức

562 lượt xemDOI:

https://doi.org/10.54939/1859-1043.j.mst.97.2024.138-147Từ khóa:

Mạng nơ ron tích chập; Học sâu; Báo cháy; Cảm biến; Phát hiện cháy; Đa thể thứcTóm tắt

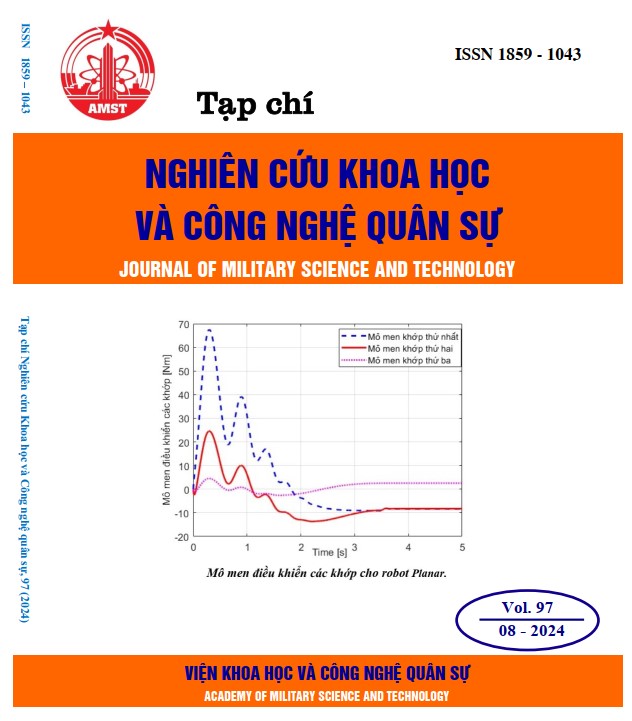

Phát hiện sớm sự cố khói và cháy trong các căn hộ được xem là một trong những yếu tố vô cùng quan trọng, giúp ngăn ngừa hậu quả nghiêm trọng do cháy nổ gây ra về con người và tài sản. Các giải pháp phổ biến hiện nay được áp dụng là dùng các loại cảm biến vật lý như cảm biến khí ga, cảm biến khói và cảm biến nhiệt độ gây ra do cháy. Tuy nhiên, việc sử dụng cảm biến vật lý sẽ có nhược điểm là thời gian phát hiện chậm hơn so với việc kết hợp nhiều luồng thông tin, đặc biệt là kết hợp với thông tin hình ảnh. Bài báo này chúng tôi đề xuất giải pháp phát hiện cháy đa thể thức, sử dụng kết hợp các cảm biến vật lý (Sensor) và cảm biến hình ảnh (Camera). Trong đó, mô hình đề xuất áp dụng kiến thức về trí tuệ nhân tạo (Artificial Intelligent-AI) và Internet vạn vật (IoT) để phát hiện khói và cháy áp dụng trong môi trường trong nhà. Giải pháp phát hiện khói và cháy bằng hình ảnh sử dụng giải thuật chắt lọc tri thức (Knowledge Distillation-KD) từ nhiều mô hình giáo viên YOLO bản đầy đủ cho mô hình YOLO bản rút gọn và cho kết quả phát hiện cao hơn lên tới 10%; mô hình rút gọn có thời gian đáp ứng nhanh hơn so với các mô hình bản đầy đủ lên tới 8.22 (ms) khi sử dụng GPU và 51.56 (ms) khi sử dụng CPU.

Tài liệu tham khảo

[1]. Đoàn Thị Hương Giang, Hồ Anh Dũng, Nguyễn Ngọc Trung, Nguyễn Trung Hiếu, “Improvement of performance of human detection in abnormal crowd using knowledge distillation for YOLO network,” Tạp chí Khoa học và Công nghệ Trường Đại học Công nghiệp Hà Nội, Tập 60 - Số 4, pp. 39-44, (2024), doi: 10.57001/huih5804.2024.124. DOI: https://doi.org/10.57001/huih5804.2024.124

[2]. Huong-Giang Doan, Ngoc-Trung Nguyen, “New blender-based augmentation method with quantitative evaluation of CNNs for hand gesture recognition”, Indonesian Journal of Electrical Engineering and Computer Science, Vol. 30, No. 2, pp. 796-806, (2023). DOI: 10.11591/ijeecs.v30.i2.pp796-806, (2023). DOI: https://doi.org/10.11591/ijeecs.v30.i2.pp796-806

[3]. Redmon Joseph, Divvala Santosh, Girshick Ross, Farhadi Ali. “YOLOv1: You Only Look Once: Unified, Real-Time Object Detection”. 779-788. 10.1109/CVPR.2016.91, (2016). DOI: https://doi.org/10.1109/CVPR.2016.91

[4]. Redmon Joseph, Farhadi Ali. “YOLO9000: Better, Faster, Stronger”. 6517-6525. 10.1109/CVPR.2017.690, (2017). DOI: https://doi.org/10.1109/CVPR.2017.690

[5]. J. Redmon, A. Farhadi. “Yolov3: An incremental improvement”. CoRR journal, Vol. abs/1804.02767, pp. 1-6, (2018).

[6]. A. Bochkovskiy, C.Y. Wang, H.Y. M. Liao. “Yolov4: Optimal speed and accuracy of object detection”. ArXiv journal, Vol. abs/2004.10934, 2020, pp. 1-17, (2004).

[7]. Glenn Jocher. “Yolov5 in pytorch”. https://github.com/ultralytics/yolov5, (2020).

[8]. Chuyi Li, Lulu Li, Hongliang Jiang, Kaiheng Weng, Yifei Geng, Liang Li, Zaidan Ke, Qingyuan Li, Meng Cheng, Weiqiang Nie, Yiduo Li, Bo Zhang, Yufei Liang, Linyuan Zhou, Xiaoming Xu, Xiangxiang Chu, Xiaoming Wei, Xiaolin Wei. “YOLOv6: A Single-Stage Object Detection Framework for Industrial Applications. Computer Vision and Pattern Recognition”, (2022).

[9]. Wang Chien-Yao, Bochkovskiy Alexey, Liao Hong-yuan. “YOLOv7: Trainable bag-of-freebies sets new state-of-the-art for real-time object detectors”. 10.48550/arXiv.2207.02696, (2022). DOI: https://doi.org/10.1109/CVPR52729.2023.00721

[10]. Jocher, G.; Chaurasia, A.; Qiu, J. “YOLO by Ultralytics,”. GitHub. (2023). Available online: https://github.com/ultralytics/ultralytics.

[11]. Wang, C., Yeh, I., & Liao, H. “YOLOv9: Learning What You Want to Learn Using Programmable Gradient Information”. ArXiv, abs/2402.13616, (2024).

[12]. https://thietbidienthongminhata.com/

[13]. R. Y. Rubinstein, “Optimization of computer simulation models with rare events,” European Journal of Operational Research, vol. 99, no. 1, pp. 89–112, (1997). DOI: https://doi.org/10.1016/S0377-2217(96)00385-2

[14]. G. E. Hinton, O. Vinyals, and J. Dean, “Distilling the knowledge in a neural network,” ArXiv, vol. abs/1503.02531, (2015).

[15]. http://canhsatpccc.gov.vn/Home/tabid/40/language/vi-VN/default.aspx